Dans le domaine de l’intelligence artificielle, la concurrence internationale est rude. Alors quand des chercheurs du CEA des instituts Joliot et Irfu tiennent la dragée haute aux start-ups et autres entreprises spécialisées en IA, on ne peut que leur tirer notre chapeau. Récit d’un succès dans le domaine de la reconstruction d’images IRM.

Parmi les approches d’intelligence artificielle qui ont le vent en poupe, le deep learning (apprentissage profond en français) et ses réseaux de neurones artificiels intéressent particulièrement les développeurs d’algorithmes de reconstruction d’images par résonance magnétique. Leur intérêt est double : les réseaux de neurones artificiels permettent de recouvrer des images d’une qualité similaire à celles obtenues à partir de jeux de données complets en n’acquérant qu’une faible fraction des données, typiquement un huitième. C’est donc in fine l’assurance de réduire aussi le temps d’examen pour chaque patient et d’accroître le nombre d’individus pris en charge chaque jour à l’hôpital. Par ailleurs, ces algorithmes reconstruisent les images beaucoup plus rapidement que les méthodes antérieures (10 à 100 fois plus vite).

Et ce n’est pas un hasard si les géants du numérique s’y intéressent. Facebook AI Research et le NYU Langone Health ont récemment lancé fastMRI, un projet collaboratif de recherche basé sur des données ouvertes. Leur but ? Pouvoir juger des performances des réseaux de neurones artificiels en cours de développement dans le monde entier et créer un référentiel pour les comparer. Le NYU Langone Health a rendu publics des jeux complets de données brutes d’IRM du genou en 2018 et du cerveau fin 2019. Pour l’imagerie cérébrale, les données ont été collectées chez 6970 individus, sur 11 scanners Siemens Healthineers différents, à 1,5 ou 3 teslas (3/7 des données proviennent d’imageurs à 1,5 T), auprès de cinq sites partenaires aux États-Unis. Elles mélangent également plusieurs contrastes d’imagerie (pondération T1, T2 ou FLAIR) qui donnent accès à des informations complémentaires sur les tissus cérébraux. Les données sont en accès libre (voir https://fastmri.med.nyu.edu/ pour les détails).

Cosmostat & Parietal : une collaboration fructueuse

La publication de données en accès libre avait incité Zaccharie Ramzi, étudiant en thèse sous la supervision de Philippe Ciuciu (équipe PARIETAL Inria-CEA, NeuroSpin, Institut joliot) et de Jean-Luc Starck (Cosmostat, Irfu CEA-CNRS) à établir une analyse comparative de plusieurs réseaux neuronaux profonds utilisés en IRM . Ce « benchmarking » est une application concrète de leur projet commun Cosmic (Compressed Sensing for Magnetic resonance Imaging and Cosmology) qui mutualise les compétences en deep learning des deux équipes pour réduire le temps d’acquisition et de reconstruction des images sans dégrader leur qualité. Cosmostat apporte au projet son expertise sur la reconstruction d’images issues de grands relevés astrophysiques comme les algorithmes, les reconstructions d’image 3D et leur représentation. L’équipe de NeuroSpin, quant à elle, apporte ses connaissances en acquisition IRM et son savoir en génie logiciel. Les problématiques entre les images astrophysiques et IRM sont les mêmes : des données manquantes et un bruit de fond qui domine sur les mesures. Cette collaboration a déjà permis d’importantes avancées avec des temps de calcul d’images astrophysiques réduit par dix après optimisation et des temps d’acquisition en imagerie 2D multicoupes passant de 4 minutes à 18 secondes grâce aux stratégies compressées implémentées dans les scanners IRM à NeuroSpin

Lors de leur première expérience avec les données du projet fastMRI, les chercheurs avaient surtout pu s’assurer de la robustesse d’algorithmes pré-existants. Alors quand Facebook AI Research and le NYU Langone Health ont annoncé la tenue en octobre 2020 de la compétition internationale « Brain FastMRI Challenge », visant à comparer les performances de différentes architectures de réseaux de neurones à partir de données sous-échantillonnées, correspondant à des examens plus rapides tels qu’ils pourraient être faits à l’avenir, c’est donc naturellement que les chercheurs du CEA ont décidé d’y participer, en utilisant leur propre algorithme.

Concrètement, les organisateurs de la compétition ont communiqué le 1er octobre le jeu de données test, sous-échantillonnées artificiellement d’un facteur (R) 4 ou 8, pour correspondre à des examens 4 à 8 fois moins longs. Avant cela, pendant plusieurs mois, la communauté internationale avait pu entraîner ses réseaux sur des données d’entraînement et de validation de façon supervisée, c’est-à-dire en connaissance des données complètes. L’intérêt des données test est bien sûr de ne pas disposer de la vérité terrain, ni des données complètes, ni des images de référence associées, pour tester à l’aveugle et sur un pied d’égalité tous les compétiteurs. Outre ces deux catégories, le challenge comportait aussi un axe non-supervisé d’apprentissage par transfert dont le but était de tester des réseaux de neurones sur des données issues d’imageurs General Electric ou Philips alors que ceux-ci avaient été entraînés sur des données Siemens Healthineers uniquement.

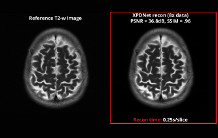

La date limite de soumission des résultats était fixée au 15 octobre. Le jury a procédé en deux étapes. D’abord, des métriques quantitatives ont été calculées, notamment le score de similarité entre les images de référence, reconstruites à partir des données complètes seulement à la disposition des organisateurs, et celles reconstruites par les participants avec leurs algorithmes (Structural Similarity – SSIM). Puis, les images ont été évaluées visuellement par des médecins radiologues sur des critères spécifiques (artefacts, netteté de l’image, rapport contraste/bruit).

Les organisateurs ont annoncé les résultats de la compétition le 11 décembre 2020, lors de la conférence internationale annuelle Neural Information Processing Systems (NeurIPS), la grande messe du machine learning. Notre trio de chercheur NeuroSpin/Cosmostat s’est classé deuxième dans les catégories supervisées parmi 19 compétiteurs. Un succès d’autant plus mérité que la concurrence était rude. Un article dédié à ce challenge et cosigné à la fois par les organisateurs du challenge, notamment Matthew Muckley de Facebook AI Research et Florian Knoll, NYU Langone , ainsi que les trois équipes de finalistes, sera publié en 2021 dans la revue IEEE Transactions on Medical Imaging.

Les principales forces de l’algorithme développé au CEA

L’algorithme que Zaccahrie Ramzi a développé contient de multiples avancées : d’abord il exploite l’une des conclusions du benchmarking effectué par les chercheurs précédemment (voir actualité juin 2020) : il est plus avantageux de développer des architectures hybrides de réseaux de neurones 2D, qui alternent les traitements entre l’espace image et l’espace d’acquisition des données (encore appelé k-space ou espace de Fourier), que de développer une architecture qui ne travaille que dans un seul des deux espaces. Ensuite, l’algorithme intègre des traitements spécifiques pour optimiser la prise en compte des données multi-canaux qui permettent de maintenir le rapport signal-sur-bruit à un niveau élevé.

De plus, pour atteindre de telles performances, les chercheurs se sont appuyés sur le super-calculateur Jean Zay de l'Institut du développement et des ressources en informatique scientifique (IDRIS). Ce centre de calcul intensif du CNRS a mis en place en 2019 un appel dynamique sur l'Intelligence Artificielle. Grâce au soutien de DRF/D3P (France Boileux-Cerneux et Christophe Calvin), l’équipe avait été sélectionnée. Les réseaux ont pu être entraînés sur les partitions GPU disposant de nœuds de cartes Nvidia V100, une référence dans le domaine.

Retrouvez la présentation de Zaccharie Ramzi pour NeurIPS :

https://slideslive.com/38942421/xpdnet-for-brain-multicoil-mri-reconstruction

Références

[1] cf. actu du 04/06/2020 https://joliot.cea.fr/drf/joliot/Pages/Actualites/Scientifiques/2020/Deep-learning-IRM-Standard-comparaison-reseaux.aspx

[2] cf. actualité du 17/02/2019 https://www.cea.fr/drf/Pages/Actualites/En-direct-des-labos/2019/IRM-haute-resolution–comment-ne-pas-y-passer-des-heures-.aspx