40 millions de fois par seconde, des paquets de protons se croisent quasiment à la vitesse de la lumière au sein des quatre détecteurs placés le long de l’anneau de 27 kilomètres de circonférence du LHC, l’accélérateur géant de particules du Cern, près de Genève. À chaque croisement, en vertu de l’équivalence entre énergie et masse, les collisions entre particules engendrent des myriades d’autres particules dont les propriétés sont autant d’informations sur les lois de notre univers.

Au cours de la campagne de prise de données qui va débuter le 5 juillet 2022, le run 3, le nombre de particules contenues dans chaque paquet sera petit à petit multiplié par deux. À la clé : un nombre de collisions de protons par seconde démultiplié, de quoi augmenter significativement les chances de révéler les contours d’un nouveau continent de l’infiniment petit au milieu d’un intense bruit expérimental.

Ces améliorations des performances du LHC, sans précédent depuis sa mise en service en 2010, vont placer les scientifiques face à un déluge de données. Cette perspective les a conduits à revoir de fond en comble la façon de conduire leurs analyses, depuis la sélection des informations pertinentes au niveau des détecteurs, jusqu’à la façon d’organiser leur archivage de long terme sur le réseau mondial de sites informatiques du LHC.

Des quatre expériences principales en cours auprès de l’accélérateur, LHCb et ALICE ont été le plus loin dans la révision de leur système de sélection et d’enregistrement. CMS et Atlas ont fait des adaptations significatives, dans l’attente de leur « grand carénage » prévu après la campagne en cours.

En fonction des objectifs scientifiques propres à chaque expérience, différentes stratégies sont mises en œuvre pour trier et organiser les données des collisions. Ainsi, Atlas et CMS, les deux détecteurs généralistes qui ont notamment découvert le boson de Higgs en 2012, recherchent des événements rarissimes. Par conséquent, le fruit de la majorité des centaines de millions de collisions qui se produisent par seconde dans leur creuset doit donc être éliminé au seul profit des événements éventuellement porteurs d’une physique « intéressante ». Pour ce faire, à chaque collision, l’analyse instantanée de quelques données succinctes permet de statuer sur la pertinence d’un événement, auquel cas la totalité de l’information le concernant est effectivement enregistrée. Si non, les détecteurs passent leur tour.

Dans le cas d’Atlas par exemple, avant le run 3, seules étaient lues systématiquement les informations issues de son calorimètre à argon liquide et de son détecteur à muons. Et encore, sur les 180 000 canaux du calorimètre, une intégration des données faisait que seulement 5 000 signaux analogiques indépendants servaient à la sélection des événements. « À partir de cette information très parcellaire, incluant une superposition de différents dépôts d’énergie où se mélangeaient les produits de plusieurs interactions, notre vision des événements à ce stade de l’analyse demeurait relativement floue, rendant par exemple difficile la distinction entre hadrons et électrons », détaille Georges Aad, au Centre de physique des particules de Marseille et membre d’Atlas.

Or, avec le run 3, le nombre de collisions quasi-simultanées de protons se produisant à chaque croisement de paquets de protons, toutes les 25 nanosecondes, va passer de 40 à 80. En revanche, le calorimètre a un temps de lecture bien plus long que la fréquence de croisement des faisceaux et sa capacité de déclenchement du détecteur, environ toutes les 10 microsecondes, demeurera inchangée. Les traces laissées par environ 2 400 interactions se superposeront donc sur les électroniques des détecteurs. Une seule solution : affiner la sélection.

Pour ce faire, de nouvelles cartes installées au niveau de l’électronique du calorimètre permettront de lire jusqu’à 34 000 canaux indépendants à la cadence maximale. Mieux, les informations en résultant seront immédiatement numérisées avant analyse par des algorithmes plus « costauds » implémentés sur un réseau de portes programmables, les FPGA (Field-programmable gate array). « De cette manière, nous pourrons en particulier estimer plus précisément l’énergie de chaque particule et mieux démêler les différentes collisions », se réjouit le physicien. De quoi in fine optimiser la sélection des événements à conserver pour une analyse complète ultérieure.

LHCb augmente la cadence

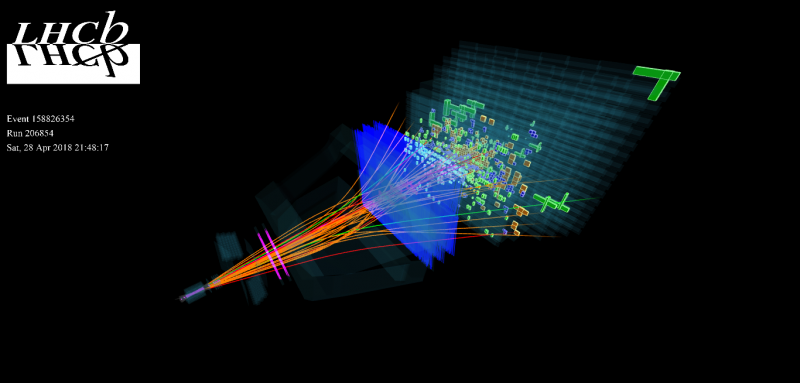

Tout comme Atlas et CMS, l’expérience LHCb, doit opérer un tri drastique parmi les collisions se produisant au sein de son détecteur géant. Avec une particularité cependant par rapport aux autres expériences : le taux de production des hadrons « beaux », les particules que LHCb étudie, est colossal et pose un problème de flux d’information à traiter. En revanche, seule quelques désintégrations particulières sont recherchées, ce qui nécessite un tri particulièrement sophistiqué. Pour le run 3, la collaboration a opté pour une véritable révolution dans la manière de conduire leurs analyses, de quoi projeter cette expérience dédiée à l’étude des désintégrations des hadrons beaux au-delà même de la campagne qui démarre.

Jusqu’alors, comme dans Atlas, la décision d’enregistrer ou pas les informations propres à une collision était prise sur la base de signatures très simples. Par exemple un muon de grande impulsion ou bien un important dépôt d’énergie dans le calorimètre. Mais cette simplicité avait un coût : le risque de « louper » certains événements potentiellement intéressants mais plus complexes à repérer, typiquement caractérisés par des particules d’énergie modeste.

Mais alors que dans LHCb le nombre de collisions par croisement va être porté à six en moyenne, contre une auparavant, engendrant sur chaque cliché une combinatoire d’événements matérialisée par plus de 200 traces, cette façon de procéder est devenue obsolète. Pour la remplacer, les spécialistes ont ainsi mis au point un système permettant d’analyser en temps réel la totalité de l’information déposée sur l’ensemble des détecteurs qui composent LHCb, de quoi sélectionner les événements sur la base d’une analyse circonstanciée de chaque collision. Comme le résume Renaud Le Gac, au Centre de physique des particules de Marseille et membre de LHCb, « avant, l’information complète sur les collisions n’était lue qu’à la fréquence de 1 MHz. Désormais cette lecture complète se fera à la fréquence des collisions, soit 40 MHz, impliquant le traitement de 40 térabits de données par seconde, ce qui est une première et un changement complet de paradigme ! »

Pour y parvenir, cette pluie de données sera concrètement acheminée depuis la caverne du détecteur par 11 000 fibres optiques connectées à 163 serveurs. Grâce à une carte FPGA développée par le CPPM, les informations associées à une même collision seront d’abord agrégées. Puis, grâce à un cadre logiciel hétérogène et des algorithmes conçus par le CPPM et le Laboratoire de physique nucléaire et des hautes énergies, à Paris, et implémenté sur des cartes graphiques (GPUs), l’ensemble pouvant traiter 5 téraoctets par seconde, les traces seront partiellement reconstruites et les particules identifiées.

Comme le détaille Dorothea vom Bruch, elle aussi au laboratoire marseillais, « les GPU sont des processeurs initialement développés pour le traitement d’images. Efficaces et relativement peu onéreux, ils se prêtent très bien à une analyse combinatoire en parallèle de milliers de collisions. » « On est parmi les premiers à en utiliser pour une analyse de physique et à démontrer que cela fonctionne », se félicite son collègue Renaud Le Gac. Au terme de cette première couche d’analyse, le taux d’événements conservés sera réduit à 1 MHz, ceux-ci étant alors inscrits sur des disques où le flot en écriture s’effectuera à 100 gigaoctets par seconde.

En parallèle, les serveurs récupèreront les données d’étalonnage qui servent pour la phase de reconstruction rapide, mais également pour la phase suivante dédiée à la reconstruction de la totalité des événements sélectionnés. « Cette deuxième phase se fera sur des CPU classiques, mais sur la base d’algorithmes refondés et parallélisés », précise Dorothea vom Bruch. Les données issues de ce traitement seront alors définitivement conservées sur les serveurs du Cern à raison de l’inscription de 10 gigaoctets de données par seconde, prêtes pour les analyses de long terme.

Une toute nouvelle infrastructure pour ALICE

Cette infrastructure d’analyse totalement nouvelle, dite sans système de sélection, est aussi celle adoptée par ALICE pour le run3. Dédiée à l’étude des propriétés du plasma de quarks et de gluons (PQG), un état extrême de la matière, cette expérience consiste à recueillir les nuées de particules qui s’échappent du PQG alors qu’il se refroidit avant de disparaître. En ce sens, ALICE est intéressée par les propriétés collectives des événements et cherche à mesurer le produit de chaque collision. Pour autant, dans les campagnes précédentes, son détecteur n’avait pas la possibilité de travailler à la cadence maximale permise par l’accélérateur. Mais après une intense cure de jouvence, l’objectif est de parvenir à multiplier par 10 la cadence de prise de données, la portant à environ 50 kHz. Comme l’explique Stefano Panebianco, au CEA et membre d’ALICE, « notre système d’analyse en ligne permettra de récupérer les données au rythme de quelques térabits par seconde, avant de les analyser sur une ferme de 500 serveurs contenant chacun 10 cœurs GPU et CPU grâce auxquels il nous sera possible de détecter des particules exotiques et/ou rares. »

Transferts de données entre les sites de la grille international de calcul et de stockage pour le LHC (WLCG)

Au-delà de ces analyses en ligne, quelle que soit leur complexité, le travail de long terme sur les données, celui qui conduit aux découvertes et aux publications scientifiques, est quant à lui mené sur la « grille » du Cern, ou plus précisément le Worldwide LHC computing grid (WLCG). Cette incroyable infrastructure, délocalisées sur 170 sites répartis dans 42 pays et sur trois continents, offre aux physiciens du LHC rien moins qu’un million de cœurs de calcul et deux exaoctets de stockage. Mieux, elle permet un accès parfaitement transparent aux données et aux logiciels pour les analyser, c’est-à-dire sans avoir à se soucier de là où ceux-ci sont physiquement localisés de par le monde.

Le Centre de calcul de l’IN2P3, à Lyon, constitue l’un des 13 sites principaux, en sus de celui du Cern, qui composent la grille mondiale, abritant à lui seul environ 10 % de l’ensemble des données du LHC. Comme l’explique Sabine Crépé-Renaudin, directrice adjointe scientifique de l’IN2P3 pour le calcul et les données, « contrairement aux détecteurs et à l’accélérateur, on ne fait jamais de pause. La grille doit évoluer en permanence tout en continuant à fonctionner. »

Ainsi, supports de stockage sur disques ou sur bandes, CPU, bases de données, logiciels d’analyse, intergiciels pour la communication et les transferts intersites… c’est à un travail de renouvellement et d’adaptation permanent que se livrent les centaines de spécialistes qui entretiennent la grille, sans laquelle les données du LHC demeureraient muettes. Et ce dans un contexte où la demande en ressource augmente de manière exponentielle : « Jusqu’à aujourd’hui, les capacités de calcul et de stockage du WLCG ont augmenté d’environ 15 % par an, et vont croître davantage encore dans les prochaines années », précise la physicienne. Elle ajoute : « pour le run 3, les équipes du Centre de calcul de Lyon ont changé les systèmes de stockage sur bandes, les protocoles d’accès aux informations et les protocoles d’authentification. Nous avons également adapté nos modèles de calcul à l’évolution des technologies, et réalisé des ‘’data challenges’’ afin de s’assurer du bon dimensionnement de nos infrastructures pour les transferts de données entre sites. »

Au-delà, le run 3 s’annonce comme une formidable opportunité pour préparer l’avènement du LHC haute luminosité, le HL-LHC, en 2029, qui verra le volume de données à traiter encore multiplié par un facteur 5 à 10. « Pour l’instant, on ne sait pas faire », admet Sabine Crépé-Renaudin. Tout au long de la campagne en cours, l’effort de R&D se déploiera donc tous azimuts : articulation FGPA, CPU, GPU et calcul haute performance en lien avec la montée en puissance des algorithmes d’intelligence artificielle à base de réseaux de neurones ; optimisation de la sécurité des données ; sans oublier les problématiques d’efficacité énergétique.

En attendant, des spécialistes de la grille aux experts en électronique des détecteurs et des algorithmes de sélection, alors qu’une nouvelle campagne de prise de données peut-être décisive pour la physique s’amorce, toutes et tous n’ont plus qu’un seul objectif : « tout ça, c’est pour faire la meilleure physique qui soit, avec à la clé, qui sait, des découvertes qui auront le potentiel de bouleverser la physique », s’enthousiasme Sabine Crépé-Renaudin. Le LHC n’en a sans doute jamais été aussi prêt.

Mathieu Grousson (les Chemineurs)