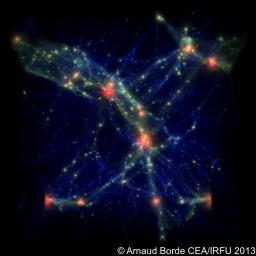

visualisation 3D d'une simulation d'un cube de l'Univers.http://irfu.cea.fr/Projets/COAST/galleries.html

Pour réaliser leurs programmes scientifiques les équipes font appel au traitement de grands volumes de données, ainsi qu’à la maitrise d’outils de simulation complexes. l’Irfu utilise les moyens de calcul nationaux et européens, comme la grille de calcul et les grands calculateurs parallèles, développe un ensemble de programmes, d’outils d’analyse et de visualisation en 3D et utilise les meilleurs calculateurs mondiaux afin de simuler l’Univers avec sa variété d’échelles, de la structure du proton à la formation des grandes structures depuis l'Univers primordial.

Applications distribuées pour les expériences

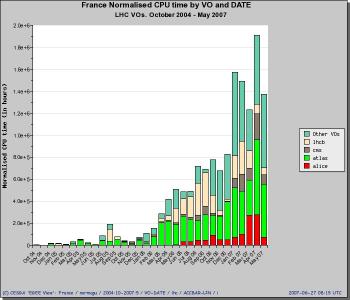

Le démarrage du LHC en 2008 a vu la mise en place de la grille LHC Computing Grid. Dans ce modèle de calcul distribué, le traitement des données a parfaitement suivi la progression de la machine LHC grâce à une montée en puissance de la grille de calcul.

La Grille se compose de quatre niveaux, numérotés de 0 à 3. Chaque niveau compte plusieurs centres de calcul et fournit un ensemble de services spécifiques.

- Le niveau 0 est le Centre de données du CERN. L’ensemble des données du LHC passent par ce nœud central. Le niveau 0 envoie les données brutes et les données reconstituées aux centres de niveau 1.

- Le niveau 1 compte 13 centres de calcul, dont un en Fance à Lyon.

- On compte environ 155 centres de niveau 2 répartis aux quatre coins de la planète (principalement des universités et des instituts de recherche)à

L’Irfu est impliqué dans le centre de calcul de Lyon pour les niveaux tier1 et tier2 et dans la grille Francilienne Grif pour les niveaux tier2 et tier3.

La grille fournit également des ressources informatiques pour le traitement de données du projet futur High Luminosity LHC au CERN, du nouvel accélérateur de particules SPIRAL 2 au GANIL, mais également de projets astrophysiques prometteurs, comme le satellite européen EUCLID ou encore CTA.

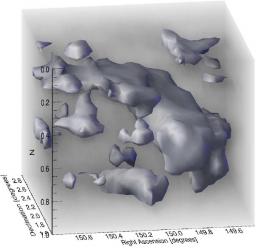

Simulation numérique (de nuages de gaz dans un cube d'univers de 65 millions d'années-lumière) produit au TGCC de Bruyères-le-Châtel

Le calcul de haute performance pour les simulations

Les simulations numériques permettent de confronter la théorie aux données et en extraire des informations pertinentes. L'iru a augmenté ses capacités de calculs en interne et bénéficie aussi d’ordinateurs massivement parallèles de niveau international, régulièrement mis à niveau dans le cadre de Genci en France et de Prace au niveau européen.

Les simulations numériques interviennent à différentes échelles de la physique ainsi que pour les developpements technologiques. Voici quelques exemples où des chercheurs de l'Irfu developpent leurs propres codes numériques ou perfectionnent ceux existants:

- Pour la compréhension de la structuration de l’Univers de la cosmologie aux systèmes stéllaires. L’ensemble de ces études s’accompagnent de moyens de calcul de haute performance, mobilisés pour la simulation, les pipelines de traitement des données, et la visualisation.

- Dans les domaines de l’infiniment petit, les codes sont développés dans les domaines de la structure des nucléons, et des modélisations des processus de fission. Profitant de l’augmentation des capacités de calcul à haute performance, une réalisation majeure a été faite avec une méthode ab initio pour décrire les noyaux à partir de potentiels d’interactions nucléon-nucléon réalistes.

- Dans les domaines technologiques, l’Irfu a développé des compétences pour la modélisation en 3D multidynamique des câbles supraconducteurs ainsi que sur la modélisation fidèle de la dynamique des faisceaux.

Applications distribuées pour les expériences de physique des hautes énergies

Les applications distribuées, c’est-à-dire fonctionnant sur un ensemble d’ordinateurs reliés en réseau, concernent de plus en plus de réalisations scientifiques de l'Irfu. Le choix d’une application distribuée peut être motivé par des besoins multiples : réaliser des analyses de données sur différents sites ; partager des résultats au sein de la communauté scientifique ; faciliter la maintenance des logiciels sur des serveurs centralisés ; gérer des flux massifs de données issus de nombreux détecteurs.

Les technologies utilisées à l'Irfu pour ces développements s’appuient principalement sur les produits « open source », autour du langage Java ou des intergiciels (voir encadré) développés par la communauté de physique des hautes énergies ou d’astrophysique. Elles ont été employées avec succès dans de nombreuses expériences.

On peut ainsi citer les serveurs de courbes de lumière ou d’images astrophysiques pour les expériences Eros ou XMM, les serveurs d’accès à des fichiers de simulation numérique d’interaction rayonnement-matière pour les programmes Odalisc ou Horizon, ou encore le serveur d’étude des supernovae de l’expérience SNLS. D’autres applications ont été réalisées dans le cadre de l’expérience Atlas au Cern, comme le serveur de suivi d’installation de lignes optiques pour le système d’alignement des chambres du spectromètre à muons, ou les serveurs de corrections géométriques et de cartographie du champ magnétique utilisés dans les programmes de trajectographie. Les applications distribuées permettent aux scientifiques de s’affranchir des problèmes techniques et du génie logiciel pour mieux se concentrer sur l’aspect algorithmique des programmes d’analyse.

Traitement d'images astrophysiques

L’observation d’objets astrophysiques, depuis le sol ou l’espace, fournit une quantité grandissante de données, perturbées par la turbulence atmosphérique ou les capacités de l’imagerie du télescope. Les images souffrent, par ailleurs, de limitations intrinsèques en raison de l’ouverture de l’instrument (taille du miroir primaire du télescope) et de la présence d’éventuelles aberrations optiques. L’exploitation optimale des instruments existants et futurs nécessite donc le développement d’outils d’analyse spécifiques.

Dans ce cadre, le programme Multirésolution, fruit d’une collaboration entre les ingénieurs-chercheurs du Dedip et du DAp, développe des méthodes et des algorithmes utilisant au mieux les connaissances sur les mécanismes de formation des images. La technique, basée sur la « transformée en ondelettes », permet de séparer dans une image les détails correspondant à différentes échelles spatiales, d’où le terme de multirésolution. Leurs champs d’application touchent à des aspects aussi variés que le filtrage, la déconvolution, la détection de forme ou la compression de données. Les thèmes de recherche mettant en œuvre ces techniques portent, entre autres, sur la détection de matière noire par effet de lentilles gravitationnelles faibles ou par effet Sunyaev Zel’dovich, la caractérisation de la structure et de la dynamique internes des étoiles (astérosismologie) ou encore la caractérisation du fond diffus cosmologique.