Projets 2008

Objectifs

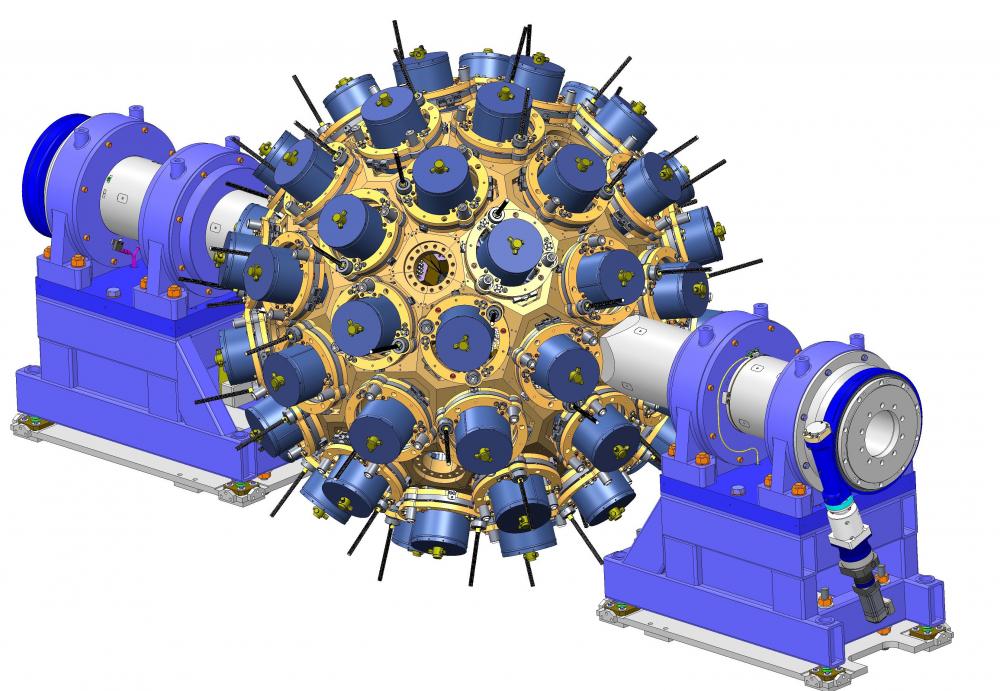

Production industrielle de quadripôles supraconducteurs double ouvertures à fort gradient (231T/m) pour l’accélérateur LHC du CERN.

- Le but est d'atteindre une fiabilité de conception pour garantir dans le temps que tous les aimants fonctionneront avec seulement 15% de marge sur le courant maximal

Contexte

Une expérience concurrente, SSC, a démarré début des années 1990 et a été stoppée en 1993

Localisation

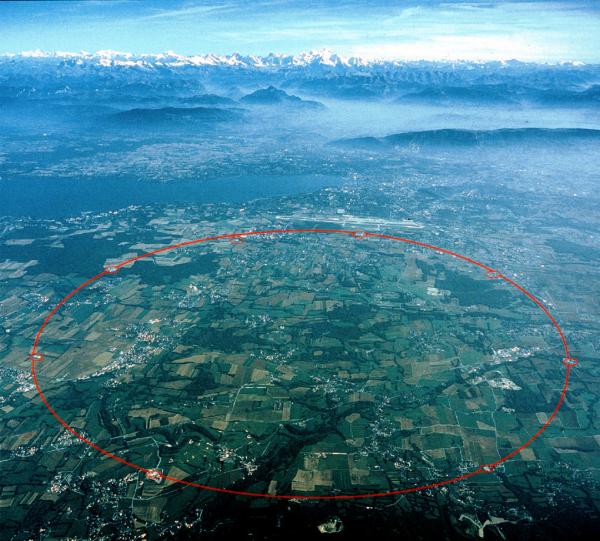

Les quadripôles feront partie du LHC situé au Cern, en Suisse.

Mission de l'Agence Spatiale Européenne pour l’exploration du ciel dans la gamme des photons gamma de basse énergie.

ESA mission to explore the low energy gamma-ray sky.

Simulation numérique en astrophysique spécialisé dans l’activité de "calcul de haute performance".

Astrophysics digital simulation for "high performance computing".

Présentation générale

SNLS a eu pour objectif la recherche de supernovae de type Ia à grand décalage spectral pour la cosmologie. Elle appartient à la seconde génération d’expériences sur ce thème, lancée suite à la découverte inattendue de l’accélération du taux d’expansion de l’Univers par les premiers programmes de supernovae lointaines à la fin des années 1990.

SNLS a utilisé le télescope Canada-France-Hawaï (CFHT) de 3,6 m de diamètre situé sur le sommet du Mauna Kéa à Hawaï et équipé de la caméra CCD à grand champ, MegaCam, conçue et assemblée à l’Irfu. Programmé pour cinq ans de 2003 à 2008, le relevé a, conformément à ses ambitions, détecté et mesuré précisément plusieurs centaines de supernovæ de type Ia à des décalages entre 0.2 et 1.0, à comparer à une cinquantaine d’objets pour les expériences antérieures. De quoi reprendre la question de l’accélération du taux d’expansion de l’Univers avec une précision accrue et une méthodologie raffinée, ce que SNLS a fait en une série de publications qui ont eu un fort retentissement dans la communauté internationale de cosmologie.

SNLS a été et reste encore le programme de recherche de supernovae à grand décalage spectral le plus performant du monde.

Atlas est l'un des détecteurs installés auprès du LHC, le collisionneur à protons du Cern dédié à l'étude du Boson de Higgs et à la recherche de nouvelle physique au delà du modele standard, qui est entré en fonction en 2008.

Objectifs :

Unification des constituants de la matière et de leurs interactions.

Atlas est l'un des deux détecteurs généralistes installés auprès du LHC, qui est entré en fonction au Cern en 2008. Atlas se propose d’explorer un nouveau domaine de la physique expérimentale. La mise en évidence de processus nouveaux et de nouvelles particules modifierait notre compréhension de la matière et de l’énergie, ainsi que les forces régissant notre Univers depuis son origine. Des questions primordiales se posent : Pourquoi et comment les particules fondamentales, qui n’avaient à la naissance de l’Univers ni leur structure ni leur masse actuelle ont-elles acquis des masses si différentes ? Pour répondre à cette question, des théories prédisent l’existence d’une nouvelle particule, le boson de Higgs, dont le champ aurait conféré leur masse à toutes les autres. La particule de masse d'environ 125 GeV dont la découverte a été annoncée par ATLAS et CMS en 2012 a toutes les propriétés pour etre ce boson de Higgs. Il existe cependant des théories qui prédisent l'existence de plusieurs bosons de Higgs. De nouvelles particules sont aussi attendues dans le cadre des extensions du modèle standard de la physique des particules : il s’agit des particules de la super-symétrie, qui associe à toutes les particules des partenaires, dotées de propriétés différentes mais apparentées. Cette super-symétrie impliquerait-elle des dimensions supplémentaires de l’espace-temps ou encore des trous noirs miniatures ?

Au tout début de l’Univers, la matière et l’antimatière existaient en quantité égale. Si la matière et l’antimatière étaient les images symétriques exactes l’une de l’autre, elles auraient dû s’annihiler totalement pour ne laisser que l’énergie. Pourquoi alors reste-t-il un excès de matière qui a pu former les galaxies, le système solaire et … nous-mêmes ? Le LHC reproduira les conditions dans lesquelles était l’Univers juste après le Big Bang, afin de nous aider à comprendre les causes de l’état actuel de l’Univers. Il nous donnera la possibilité d’expliquer pourquoi la matière la plus abondante dans l’Univers est la matière cachée, encore inconnue. Si elle est constituée de nouvelles particules, Atlas pourrait être en mesure de les découvrir.

Thèmes/programmes associés

- Les constituants ultimes de la matière / La physique au LHC

- Aimants et accélérateurs / Les aimants supraconducteurs

- Innovation pour les systèmes de détection / Développements de détecteurs

- Innovation pour les systèmes de détection / Traitement du signal et systèmes « temps réel »

L’expérience Alice est dédiée à l’étude de la matière nucléaire dans ses états extrêmes de température et de densité. Elle est spécialement conçue pour tester la théorie fondamentale de l’interaction forte, la Chromodynamique Quantique (QCD), qui prévoit l’existence de ce nouvel état de la matière qui est le plasma de quarks et de gluons (QGP).

Objectifs

De grandes questions se posent concernant la naissance de l’Univers. La matière ordinaire de l'Univers actuel est composée d'atomes, constitués d'un noyau, fait de protons et de neutrons, entouré d'un nuage d'électrons. Les protons et les neutrons sont eux-mêmes constitués de quarks, les briques les plus élémentaires de la matière. Juste après le Big Bang, dans les tous premiers moments de la création de l’Univers, la temperature de celui-ci depassait les 2000 milliards de degrées (environ 100 000 fois plus chaud que le centre du soleil), l'Univers tout entier était dans un état de quarks et de gluons deconfine : le plasma de quarks et de gluons (QGP).

Pourquoi et comment les hadrons (assemblages actuels de particules élémentaires) se sont-ils constitués? Quelle sont les propriètes du QGP. Peut-on récréer l'Univers primordial en laboratoire. Ce sont les questions que ALICE tente de repondre.

Présentation générale:

Objectifs - contexte:

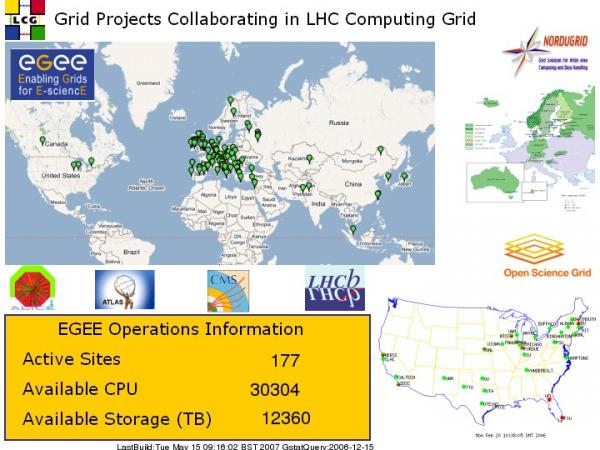

Le projet de grille de calcul au service de la recherche d’Ile de France GRIF a pour objectif la mise en place d’une grille de calcul fédérant les grands centres de recherche de la région parisienne autour d’un outil commun dans le cadre de la grille européenne EGEE et de la grille mondiale LCG.

La très forte croissance des besoins en calcul scientifique liée à l’exploitation de nouveaux instruments (citons par exemple les accélérateurs de très haute énergie et/ou intensité en physique subatomique, les télescopes et satellites en astrophysique, bases de données liées au décodage du génome ou à l’imagerie en biologie et en médecine, les nombreux capteurs en science de la Terre) nécessite la mise en place de nouvelles infrastructures de calcul. La voie la plus prometteuse, vigoureusement poursuivie actuellement au CNRS et au CEA, est basée sur le concept de grilles de calcul.

Les très hautes performances des réseaux informatiques atteignant maintenant de façon courante des débits de plusieurs dizaines de Gigabits par seconde (Gbit/s ) ont permis d’envisager la mutualisation des moyens de calcul qu’ils soient de taille modeste (locaux et régionaux) ou de taille plus importante (centres de calcul nationaux et internationaux).

Pour cela il a fallu développer les logiciels spécifiques (“middleware“) permettant la mise en commun des données et des programmes de traitement. Le caractère distribué d’une telle infrastructure est en adéquation avec la répartition géographique de ses utilisateurs tant à l’intérieur d’une même communauté, ou organisation virtuelle, que globalement. La très grande flexibilité de la grille de calcul et son allocation dynamique des ressources dans une communauté ainsi qu’entre les communautés rendent possible une forte mutualisation des ressources et contribuent à rendre ce modèle très économique et particulièrement bien adapté. Grâce à une grille de calcul il est par exemple possible de répondre à des situations d’urgence : simulations liées à une catastrophe naturelle, à une opportunité ou une urgence scientifique, sans avoir à immobiliser du matériel inutilement en attendant qu’une telle situation se produise.

Moyens d'investigation :

Une Grille de calcul est composée de trois éléments principaux:

- un ou des éléments de stockage (SE) constitué de serveurs de fichier munis d'un espace de stockage

- un ou des éléments de calcul (CE) constitué d'un gestionaire de batch gérant un ensemble de machines de calcul (WN)

- des machines de service assurant entre autre les fonctionnalité de publication des ressources (BDII), de supervision (MON)et de point accès à la grille par une ou des interfaces utilisateur (UI)

AGATA (Advanced Gamma-ray Tracking Array) est un spectromètre γ haute résolution de nouvelle génération, permettant d’effectuer des corrections Doppler inédites, grâce à la combinaison des différents éléments : une segmentation fine des cristaux HPGe, des algorithmes efficaces d’analyse de la forme des signaux, ceci permettant l’identification des points d’interactiion afin de reconstruire les traces des rayons gamma.

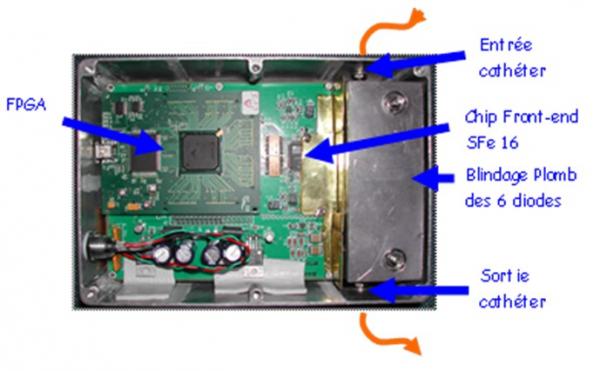

A.R.T. pour Analyse de paramètres physiologiques du Rongeur sous imagerie TEP est un projet d’instrumentation biomédicale. Il s’inscrit dans le cadre des activités que l'Irfu entretient avec la thématique des sciences du vivant.

L’objectif de ce projet est la conception et la réalisation d’un instrument permettant la mesure de la fonction d’entrée chez le rongeur simultanément à un examen TEP. Le système A.R.T. permettra d’automatiser la chaîne complète depuis le prélèvement sanguin jusqu’au comptage plasma avec une amélioration sur la précision de mesure et une limitation de la dose d’exposition du personnel. La méthode automatisée viendra remplacer la méthode manuelle présentant de nombreux inconvénients quant à sa mise en œuvre et à la fiabilité des mesures.

Ce système de mesure automatique de la fonction d’entrée est nécessaire dans le cadre des développements de nouveaux médicaments ou de nouveaux traceurs (où les prélèvements sanguins sont indispensables) et vient répondre aux besoins des biologistes.

Il existe des méthodes permettant de prélever automatiquement des micro échantillons sanguins et de compter leur activité (Université de Sherbrooke, Canada ; Cardiovascular Center Research Institute à Osaka, Japon ; UCLA Dpt of Molecular and Medical Pharmacology, USA). Ces projets sont en cours de développement ou déjà commercialisé (projet canadien) mais ne permettent de réaliser automatiquement ni l’extraction en ligne du plasma, ni les mesures de la concentration radioactive sur le plasma seul. Le projet A.R.T. propose de réaliser un développement instrumental et méthodologique pour des études précliniques en imagerie TEP (Tomographie par Emission de Positons). Le système a pour objectif de réaliser une chaîne complète automatique assurant la mesure de la fonction d’entrée (concentration du traceur dans le sang artériel de l’animal en fonction du temps) simultanément à l’imagerie, depuis le prélèvement de micro échantillons sanguins jusqu’au comptage plasma.

Objectif

L’exploitation scientifique du LHC (Large Hadron Collider) qui sera mis en service au CERN à partir de l’été 2007, sera la priorité des prochaines années en physique des hautes énergies.

La caractérisation fine de ses découvertes, et l’exploration exhaustive des phénomènes autour de l’échelle du TeV nécessiteront d’autres grands instruments, en particulier des collisionneurs électron positon. L’énergie requise, qui pourrait être de plusieurs TeV devrait être précisée à la lumière des premiers résultats du LHC, c’est-à-dire vers 2010. Deux projets de collisionneur, basés sur des technologies différentes, sont actuellement à l’étude. Le projet ILC, d’énergie 500 GeV et extensible jusqu’à 1 TeV fait appel à la technologie supraconductrice. Le projet CLIC, de plus haute énergie (3-5 TeV) utilise des cavités en cuivre haute fréquence visant des champs accélérateurs de 150 MV/m et adopte un schéma novateur, appelé communément « accélération à deux faisceaux ». Ce nouveau concept, s’il est reconnu être le seul aujourd’hui permettant d’atteindre des énergies de plusieurs TeV, est néanmoins ambitieux et présente des défis technologiques.

Le programme de R&D sur CLIC, initié par le CERN, a pour objectif de démontrer la faisabilité technique des points critiques du projet (comme le test des structures accélératrices au gradient nominal) avant la date de 2010 en construisant CTF3, plateforme d’essai de 3ème génération de CLIC, dans le cadre d’une collaboration internationale.

Localisation

Le CLIC/CTF3 est actuellement en construction au CERN à Genève.

L’expérience Alice est dédiée à l’étude de la matière nucléaire dans ses états extrêmes de température et de densité. Elle est spécialement conçue pour tester la théorie fondamentale de l’interaction forte, la Chromodynamique Quantique (QCD), qui prévoit l’existence de ce nouvel état de la matière qui est le plasma de quarks et de gluons (QGP).

Objectifs

De grandes questions se posent concernant la naissance de l’Univers. La matière ordinaire de l'Univers actuel est composée d'atomes, constitués d'un noyau, fait de protons et de neutrons, entouré d'un nuage d'électrons. Les protons et les neutrons sont eux-mêmes constitués de quarks, les briques les plus élémentaires de la matière. Juste après le Big Bang, dans les tous premiers moments de la création de l’Univers, la temperature de celui-ci depassait les 2000 milliards de degrées (environ 100 000 fois plus chaud que le centre du soleil), l'Univers tout entier était dans un état de quarks et de gluons deconfine : le plasma de quarks et de gluons (QGP).

Pourquoi et comment les hadrons (assemblages actuels de particules élémentaires) se sont-ils constitués? Quelle sont les propriètes du QGP. Peut-on récréer l'Univers primordial en laboratoire. Ce sont les questions que ALICE tente de repondre.

Présentation générale:

Objectifs - contexte:

Le projet de grille de calcul au service de la recherche d’Ile de France GRIF a pour objectif la mise en place d’une grille de calcul fédérant les grands centres de recherche de la région parisienne autour d’un outil commun dans le cadre de la grille européenne EGEE et de la grille mondiale LCG.

La très forte croissance des besoins en calcul scientifique liée à l’exploitation de nouveaux instruments (citons par exemple les accélérateurs de très haute énergie et/ou intensité en physique subatomique, les télescopes et satellites en astrophysique, bases de données liées au décodage du génome ou à l’imagerie en biologie et en médecine, les nombreux capteurs en science de la Terre) nécessite la mise en place de nouvelles infrastructures de calcul. La voie la plus prometteuse, vigoureusement poursuivie actuellement au CNRS et au CEA, est basée sur le concept de grilles de calcul.

Les très hautes performances des réseaux informatiques atteignant maintenant de façon courante des débits de plusieurs dizaines de Gigabits par seconde (Gbit/s ) ont permis d’envisager la mutualisation des moyens de calcul qu’ils soient de taille modeste (locaux et régionaux) ou de taille plus importante (centres de calcul nationaux et internationaux).

Pour cela il a fallu développer les logiciels spécifiques (“middleware“) permettant la mise en commun des données et des programmes de traitement. Le caractère distribué d’une telle infrastructure est en adéquation avec la répartition géographique de ses utilisateurs tant à l’intérieur d’une même communauté, ou organisation virtuelle, que globalement. La très grande flexibilité de la grille de calcul et son allocation dynamique des ressources dans une communauté ainsi qu’entre les communautés rendent possible une forte mutualisation des ressources et contribuent à rendre ce modèle très économique et particulièrement bien adapté. Grâce à une grille de calcul il est par exemple possible de répondre à des situations d’urgence : simulations liées à une catastrophe naturelle, à une opportunité ou une urgence scientifique, sans avoir à immobiliser du matériel inutilement en attendant qu’une telle situation se produise.

Moyens d'investigation :

Une Grille de calcul est composée de trois éléments principaux:

- un ou des éléments de stockage (SE) constitué de serveurs de fichier munis d'un espace de stockage

- un ou des éléments de calcul (CE) constitué d'un gestionaire de batch gérant un ensemble de machines de calcul (WN)

- des machines de service assurant entre autre les fonctionnalité de publication des ressources (BDII), de supervision (MON)et de point accès à la grille par une ou des interfaces utilisateur (UI)

Simulation numérique en astrophysique spécialisé dans l’activité de "calcul de haute performance".

Astrophysics digital simulation for "high performance computing".

AGATA (Advanced Gamma-ray Tracking Array) est un spectromètre γ haute résolution de nouvelle génération, permettant d’effectuer des corrections Doppler inédites, grâce à la combinaison des différents éléments : une segmentation fine des cristaux HPGe, des algorithmes efficaces d’analyse de la forme des signaux, ceci permettant l’identification des points d’interactiion afin de reconstruire les traces des rayons gamma.

Présentation générale

SNLS a eu pour objectif la recherche de supernovae de type Ia à grand décalage spectral pour la cosmologie. Elle appartient à la seconde génération d’expériences sur ce thème, lancée suite à la découverte inattendue de l’accélération du taux d’expansion de l’Univers par les premiers programmes de supernovae lointaines à la fin des années 1990.

SNLS a utilisé le télescope Canada-France-Hawaï (CFHT) de 3,6 m de diamètre situé sur le sommet du Mauna Kéa à Hawaï et équipé de la caméra CCD à grand champ, MegaCam, conçue et assemblée à l’Irfu. Programmé pour cinq ans de 2003 à 2008, le relevé a, conformément à ses ambitions, détecté et mesuré précisément plusieurs centaines de supernovæ de type Ia à des décalages entre 0.2 et 1.0, à comparer à une cinquantaine d’objets pour les expériences antérieures. De quoi reprendre la question de l’accélération du taux d’expansion de l’Univers avec une précision accrue et une méthodologie raffinée, ce que SNLS a fait en une série de publications qui ont eu un fort retentissement dans la communauté internationale de cosmologie.

SNLS a été et reste encore le programme de recherche de supernovae à grand décalage spectral le plus performant du monde.

Atlas est l'un des détecteurs installés auprès du LHC, le collisionneur à protons du Cern dédié à l'étude du Boson de Higgs et à la recherche de nouvelle physique au delà du modele standard, qui est entré en fonction en 2008.

Objectifs :

Unification des constituants de la matière et de leurs interactions.

Atlas est l'un des deux détecteurs généralistes installés auprès du LHC, qui est entré en fonction au Cern en 2008. Atlas se propose d’explorer un nouveau domaine de la physique expérimentale. La mise en évidence de processus nouveaux et de nouvelles particules modifierait notre compréhension de la matière et de l’énergie, ainsi que les forces régissant notre Univers depuis son origine. Des questions primordiales se posent : Pourquoi et comment les particules fondamentales, qui n’avaient à la naissance de l’Univers ni leur structure ni leur masse actuelle ont-elles acquis des masses si différentes ? Pour répondre à cette question, des théories prédisent l’existence d’une nouvelle particule, le boson de Higgs, dont le champ aurait conféré leur masse à toutes les autres. La particule de masse d'environ 125 GeV dont la découverte a été annoncée par ATLAS et CMS en 2012 a toutes les propriétés pour etre ce boson de Higgs. Il existe cependant des théories qui prédisent l'existence de plusieurs bosons de Higgs. De nouvelles particules sont aussi attendues dans le cadre des extensions du modèle standard de la physique des particules : il s’agit des particules de la super-symétrie, qui associe à toutes les particules des partenaires, dotées de propriétés différentes mais apparentées. Cette super-symétrie impliquerait-elle des dimensions supplémentaires de l’espace-temps ou encore des trous noirs miniatures ?

Au tout début de l’Univers, la matière et l’antimatière existaient en quantité égale. Si la matière et l’antimatière étaient les images symétriques exactes l’une de l’autre, elles auraient dû s’annihiler totalement pour ne laisser que l’énergie. Pourquoi alors reste-t-il un excès de matière qui a pu former les galaxies, le système solaire et … nous-mêmes ? Le LHC reproduira les conditions dans lesquelles était l’Univers juste après le Big Bang, afin de nous aider à comprendre les causes de l’état actuel de l’Univers. Il nous donnera la possibilité d’expliquer pourquoi la matière la plus abondante dans l’Univers est la matière cachée, encore inconnue. Si elle est constituée de nouvelles particules, Atlas pourrait être en mesure de les découvrir.

Thèmes/programmes associés

- Les constituants ultimes de la matière / La physique au LHC

- Aimants et accélérateurs / Les aimants supraconducteurs

- Innovation pour les systèmes de détection / Développements de détecteurs

- Innovation pour les systèmes de détection / Traitement du signal et systèmes « temps réel »

A.R.T. pour Analyse de paramètres physiologiques du Rongeur sous imagerie TEP est un projet d’instrumentation biomédicale. Il s’inscrit dans le cadre des activités que l'Irfu entretient avec la thématique des sciences du vivant.

L’objectif de ce projet est la conception et la réalisation d’un instrument permettant la mesure de la fonction d’entrée chez le rongeur simultanément à un examen TEP. Le système A.R.T. permettra d’automatiser la chaîne complète depuis le prélèvement sanguin jusqu’au comptage plasma avec une amélioration sur la précision de mesure et une limitation de la dose d’exposition du personnel. La méthode automatisée viendra remplacer la méthode manuelle présentant de nombreux inconvénients quant à sa mise en œuvre et à la fiabilité des mesures.

Ce système de mesure automatique de la fonction d’entrée est nécessaire dans le cadre des développements de nouveaux médicaments ou de nouveaux traceurs (où les prélèvements sanguins sont indispensables) et vient répondre aux besoins des biologistes.

Il existe des méthodes permettant de prélever automatiquement des micro échantillons sanguins et de compter leur activité (Université de Sherbrooke, Canada ; Cardiovascular Center Research Institute à Osaka, Japon ; UCLA Dpt of Molecular and Medical Pharmacology, USA). Ces projets sont en cours de développement ou déjà commercialisé (projet canadien) mais ne permettent de réaliser automatiquement ni l’extraction en ligne du plasma, ni les mesures de la concentration radioactive sur le plasma seul. Le projet A.R.T. propose de réaliser un développement instrumental et méthodologique pour des études précliniques en imagerie TEP (Tomographie par Emission de Positons). Le système a pour objectif de réaliser une chaîne complète automatique assurant la mesure de la fonction d’entrée (concentration du traceur dans le sang artériel de l’animal en fonction du temps) simultanément à l’imagerie, depuis le prélèvement de micro échantillons sanguins jusqu’au comptage plasma.

Objectif

L’exploitation scientifique du LHC (Large Hadron Collider) qui sera mis en service au CERN à partir de l’été 2007, sera la priorité des prochaines années en physique des hautes énergies.

La caractérisation fine de ses découvertes, et l’exploration exhaustive des phénomènes autour de l’échelle du TeV nécessiteront d’autres grands instruments, en particulier des collisionneurs électron positon. L’énergie requise, qui pourrait être de plusieurs TeV devrait être précisée à la lumière des premiers résultats du LHC, c’est-à-dire vers 2010. Deux projets de collisionneur, basés sur des technologies différentes, sont actuellement à l’étude. Le projet ILC, d’énergie 500 GeV et extensible jusqu’à 1 TeV fait appel à la technologie supraconductrice. Le projet CLIC, de plus haute énergie (3-5 TeV) utilise des cavités en cuivre haute fréquence visant des champs accélérateurs de 150 MV/m et adopte un schéma novateur, appelé communément « accélération à deux faisceaux ». Ce nouveau concept, s’il est reconnu être le seul aujourd’hui permettant d’atteindre des énergies de plusieurs TeV, est néanmoins ambitieux et présente des défis technologiques.

Le programme de R&D sur CLIC, initié par le CERN, a pour objectif de démontrer la faisabilité technique des points critiques du projet (comme le test des structures accélératrices au gradient nominal) avant la date de 2010 en construisant CTF3, plateforme d’essai de 3ème génération de CLIC, dans le cadre d’une collaboration internationale.

Localisation

Le CLIC/CTF3 est actuellement en construction au CERN à Genève.

L’expérience Alice est dédiée à l’étude de la matière nucléaire dans ses états extrêmes de température et de densité. Elle est spécialement conçue pour tester la théorie fondamentale de l’interaction forte, la Chromodynamique Quantique (QCD), qui prévoit l’existence de ce nouvel état de la matière qui est le plasma de quarks et de gluons (QGP).

Objectifs

De grandes questions se posent concernant la naissance de l’Univers. La matière ordinaire de l'Univers actuel est composée d'atomes, constitués d'un noyau, fait de protons et de neutrons, entouré d'un nuage d'électrons. Les protons et les neutrons sont eux-mêmes constitués de quarks, les briques les plus élémentaires de la matière. Juste après le Big Bang, dans les tous premiers moments de la création de l’Univers, la temperature de celui-ci depassait les 2000 milliards de degrées (environ 100 000 fois plus chaud que le centre du soleil), l'Univers tout entier était dans un état de quarks et de gluons deconfine : le plasma de quarks et de gluons (QGP).

Pourquoi et comment les hadrons (assemblages actuels de particules élémentaires) se sont-ils constitués? Quelle sont les propriètes du QGP. Peut-on récréer l'Univers primordial en laboratoire. Ce sont les questions que ALICE tente de repondre.

AGATA (Advanced Gamma-ray Tracking Array) est un spectromètre γ haute résolution de nouvelle génération, permettant d’effectuer des corrections Doppler inédites, grâce à la combinaison des différents éléments : une segmentation fine des cristaux HPGe, des algorithmes efficaces d’analyse de la forme des signaux, ceci permettant l’identification des points d’interactiion afin de reconstruire les traces des rayons gamma.

Atlas est l'un des détecteurs installés auprès du LHC, le collisionneur à protons du Cern dédié à l'étude du Boson de Higgs et à la recherche de nouvelle physique au delà du modele standard, qui est entré en fonction en 2008.

Objectifs :

Unification des constituants de la matière et de leurs interactions.

Atlas est l'un des deux détecteurs généralistes installés auprès du LHC, qui est entré en fonction au Cern en 2008. Atlas se propose d’explorer un nouveau domaine de la physique expérimentale. La mise en évidence de processus nouveaux et de nouvelles particules modifierait notre compréhension de la matière et de l’énergie, ainsi que les forces régissant notre Univers depuis son origine. Des questions primordiales se posent : Pourquoi et comment les particules fondamentales, qui n’avaient à la naissance de l’Univers ni leur structure ni leur masse actuelle ont-elles acquis des masses si différentes ? Pour répondre à cette question, des théories prédisent l’existence d’une nouvelle particule, le boson de Higgs, dont le champ aurait conféré leur masse à toutes les autres. La particule de masse d'environ 125 GeV dont la découverte a été annoncée par ATLAS et CMS en 2012 a toutes les propriétés pour etre ce boson de Higgs. Il existe cependant des théories qui prédisent l'existence de plusieurs bosons de Higgs. De nouvelles particules sont aussi attendues dans le cadre des extensions du modèle standard de la physique des particules : il s’agit des particules de la super-symétrie, qui associe à toutes les particules des partenaires, dotées de propriétés différentes mais apparentées. Cette super-symétrie impliquerait-elle des dimensions supplémentaires de l’espace-temps ou encore des trous noirs miniatures ?

Au tout début de l’Univers, la matière et l’antimatière existaient en quantité égale. Si la matière et l’antimatière étaient les images symétriques exactes l’une de l’autre, elles auraient dû s’annihiler totalement pour ne laisser que l’énergie. Pourquoi alors reste-t-il un excès de matière qui a pu former les galaxies, le système solaire et … nous-mêmes ? Le LHC reproduira les conditions dans lesquelles était l’Univers juste après le Big Bang, afin de nous aider à comprendre les causes de l’état actuel de l’Univers. Il nous donnera la possibilité d’expliquer pourquoi la matière la plus abondante dans l’Univers est la matière cachée, encore inconnue. Si elle est constituée de nouvelles particules, Atlas pourrait être en mesure de les découvrir.

Thèmes/programmes associés

- Les constituants ultimes de la matière / La physique au LHC

- Aimants et accélérateurs / Les aimants supraconducteurs

- Innovation pour les systèmes de détection / Développements de détecteurs

- Innovation pour les systèmes de détection / Traitement du signal et systèmes « temps réel »

Objectifs

Production industrielle de quadripôles supraconducteurs double ouvertures à fort gradient (231T/m) pour l’accélérateur LHC du CERN.

- Le but est d'atteindre une fiabilité de conception pour garantir dans le temps que tous les aimants fonctionneront avec seulement 15% de marge sur le courant maximal

Contexte

Une expérience concurrente, SSC, a démarré début des années 1990 et a été stoppée en 1993

Localisation

Les quadripôles feront partie du LHC situé au Cern, en Suisse.

Objectif

L’exploitation scientifique du LHC (Large Hadron Collider) qui sera mis en service au CERN à partir de l’été 2007, sera la priorité des prochaines années en physique des hautes énergies.

La caractérisation fine de ses découvertes, et l’exploration exhaustive des phénomènes autour de l’échelle du TeV nécessiteront d’autres grands instruments, en particulier des collisionneurs électron positon. L’énergie requise, qui pourrait être de plusieurs TeV devrait être précisée à la lumière des premiers résultats du LHC, c’est-à-dire vers 2010. Deux projets de collisionneur, basés sur des technologies différentes, sont actuellement à l’étude. Le projet ILC, d’énergie 500 GeV et extensible jusqu’à 1 TeV fait appel à la technologie supraconductrice. Le projet CLIC, de plus haute énergie (3-5 TeV) utilise des cavités en cuivre haute fréquence visant des champs accélérateurs de 150 MV/m et adopte un schéma novateur, appelé communément « accélération à deux faisceaux ». Ce nouveau concept, s’il est reconnu être le seul aujourd’hui permettant d’atteindre des énergies de plusieurs TeV, est néanmoins ambitieux et présente des défis technologiques.

Le programme de R&D sur CLIC, initié par le CERN, a pour objectif de démontrer la faisabilité technique des points critiques du projet (comme le test des structures accélératrices au gradient nominal) avant la date de 2010 en construisant CTF3, plateforme d’essai de 3ème génération de CLIC, dans le cadre d’une collaboration internationale.

Localisation

Le CLIC/CTF3 est actuellement en construction au CERN à Genève.

Atlas est l'un des détecteurs installés auprès du LHC, le collisionneur à protons du Cern dédié à l'étude du Boson de Higgs et à la recherche de nouvelle physique au delà du modele standard, qui est entré en fonction en 2008.

Objectifs :

Unification des constituants de la matière et de leurs interactions.

Atlas est l'un des deux détecteurs généralistes installés auprès du LHC, qui est entré en fonction au Cern en 2008. Atlas se propose d’explorer un nouveau domaine de la physique expérimentale. La mise en évidence de processus nouveaux et de nouvelles particules modifierait notre compréhension de la matière et de l’énergie, ainsi que les forces régissant notre Univers depuis son origine. Des questions primordiales se posent : Pourquoi et comment les particules fondamentales, qui n’avaient à la naissance de l’Univers ni leur structure ni leur masse actuelle ont-elles acquis des masses si différentes ? Pour répondre à cette question, des théories prédisent l’existence d’une nouvelle particule, le boson de Higgs, dont le champ aurait conféré leur masse à toutes les autres. La particule de masse d'environ 125 GeV dont la découverte a été annoncée par ATLAS et CMS en 2012 a toutes les propriétés pour etre ce boson de Higgs. Il existe cependant des théories qui prédisent l'existence de plusieurs bosons de Higgs. De nouvelles particules sont aussi attendues dans le cadre des extensions du modèle standard de la physique des particules : il s’agit des particules de la super-symétrie, qui associe à toutes les particules des partenaires, dotées de propriétés différentes mais apparentées. Cette super-symétrie impliquerait-elle des dimensions supplémentaires de l’espace-temps ou encore des trous noirs miniatures ?

Au tout début de l’Univers, la matière et l’antimatière existaient en quantité égale. Si la matière et l’antimatière étaient les images symétriques exactes l’une de l’autre, elles auraient dû s’annihiler totalement pour ne laisser que l’énergie. Pourquoi alors reste-t-il un excès de matière qui a pu former les galaxies, le système solaire et … nous-mêmes ? Le LHC reproduira les conditions dans lesquelles était l’Univers juste après le Big Bang, afin de nous aider à comprendre les causes de l’état actuel de l’Univers. Il nous donnera la possibilité d’expliquer pourquoi la matière la plus abondante dans l’Univers est la matière cachée, encore inconnue. Si elle est constituée de nouvelles particules, Atlas pourrait être en mesure de les découvrir.

Thèmes/programmes associés

- Les constituants ultimes de la matière / La physique au LHC

- Aimants et accélérateurs / Les aimants supraconducteurs

- Innovation pour les systèmes de détection / Développements de détecteurs

- Innovation pour les systèmes de détection / Traitement du signal et systèmes « temps réel »

Objectifs

Production industrielle de quadripôles supraconducteurs double ouvertures à fort gradient (231T/m) pour l’accélérateur LHC du CERN.

- Le but est d'atteindre une fiabilité de conception pour garantir dans le temps que tous les aimants fonctionneront avec seulement 15% de marge sur le courant maximal

Contexte

Une expérience concurrente, SSC, a démarré début des années 1990 et a été stoppée en 1993

Localisation

Les quadripôles feront partie du LHC situé au Cern, en Suisse.